Siguiendo con el tema de la semana he pedido un par de reviews y me he metido un poco más a fondo en teoria de juegos. Lo primero para no perderme ha sido el clasificar todos los juegos simetricos, de dos jugadores con dos posibles movimientos (C y D, Colaborar o Desertar) y cuatro posibles resultados: cobramos R si ambos colaboramos, S si Colaboramos pero el contrario Deserta, T en el caso reciproco, y P si ambos desertamos. En principio hay 24 posibles formas de ordenar los cuatro valores, y con el convenio R>P se reducirian a 12. La clasificación, incluyendo tambien juegos asimetricos, la hicieron en los sesenta Rapoport and Guyer (“A taxonomy of 2×2 games” , aunque es mas facil encontrar en la red una mas reciente de Robinson and Goforth del año 2005.

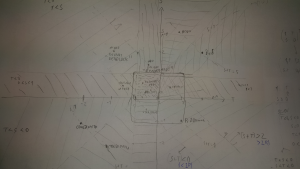

Podemos ver los distintos juegos sobre el plano T-S: Dado que tanto T como S pueden ser estar en tres posiciones respecto a P<R, tenemos nueve juegos:

| ||

Mixed | Pure ||

Delight | Delight || Hero

| ||

------------------+---------++------------------S=R

Mixed Harmony | Harmony || Chicken

==================+=========++==================S=P

| ||

Coordination | Stag || Prisoner Dilemma

| Hunt ||

T=P T=R

Además en los casos Coordination, Harmony y Hero puede que T sea mayor que S o lo contrario, lo que nos define, cortando esos sectores en diagonal tres juegos mas, y ya tenemos el total de 12. En el caso especial de R=P=0 es posible intercambiar T y S, y solo quedarian Hero, Coordination y Prisoner Dilema (o MD).

En la práctica se suele normalizar con P=0 y R=1, y estudiar un cuadrado con S en [-1 .. 1] y T en [0 .. 2], lo que captura esencialmente cinco juegos: Chicken, PD, SH, y los dos triangulos en los que se ha divido Harmony (a veces al triangulo inferior se le llama “No Conflict”). Esto se hace asi porque realmente las propiedades de equilibrio del juego pivotan sobre si S es mejor o peor resultado que P y si T es mejor o peor resultado que R. Esto es, alrededor del punto (T=1,S=0) en la normalizacion habitual.

El juego del “bote de una loteria de un solo numero” que hemos jugado en los dos post anteriores esta un poco fuera de la normalizacion: vemos que tiene la propiedad de que S=R=0, llamando “Colaborar” al hecho de no comprar el billete (sí, suena raro, pero se trata de mantener el convenio R > P), P=bote/2 – ticket < 0, y T =Bote – Ticket > 0. Se trata pues de un caso limite de Chicken: cuando los dos jugadores compran billete, ambos pierden, al igual que cuando ninguno de los dos conductores del chicken gira para apartarse. La unica complicacion es que en esta normalizacion no podriamos estudiar bien el caso en el que el bote crece tanto que se hace mayor que dos veces el ticket, pero la verdad es que tampoco vamos a hacerlo; ya fue suficiente con dos posts sobre la loteria dichosa.

Lo que si que me interesa por encima de esta clasificacion es una circunstancia que puede marcar diferencias cuando el juego se plantea repetidas veces: los casos en los que a los dos jugadores les mereceria mas la pena pactar para ir llevandose alternativamente S + T en vez de R + R. Esta linea S+T > 2R, o simplemente S+T > 2 en la normalizacion habitual, deberia tener algun efecto en la clasificacion, pero al no afectar para la construccion de los equilibrios de Nash tampoco afecta a las simulaciones con modelos evolutivos, al menos no en los casos mas comunes. Se podria decir que el juego no es capaz de explotar adecuadamente los “recursos naturales”.

En el caso concreto de Chicken (Snowdrift, Hawks and Doves), calculemos el equilibrio mixto. Si el primer jugador tiene una probabilidad p de jugar “C”, y el segundo una probabilidad q de lo mismo, el cobro del primer jugador sera a la larga:

p q R + p (1-q) S + (1-p) q T + (1-p) (1-q) P

o, ya con R=1, P=0, y separando terminos

p ( q (1-S-T) + S) ) + q T

la condicion de equilibrio es que el termino multiplicando p sea nulo, esto es

q= S / (S+T-1)

Y cuando toda la poblacion ha evolucionado hacia el punto de equilibrio q el valor extraido por cualquier jugador es a la larga el dado por la primera ecuacion poniento tambien p=q, esto es

S T / (S+T-1)

Incidentalmente, notad que la condicion de equilibrio es una recta que pasa por S=0, T=1. En cierto modo esta familia de rectas, para q entre cero y uno, va interpolando desde el dilema del prisionero hasta Harmony. La recta para q=1/2 es paralela a la diagonal S=T.

Otra pregunta seria, sabiendo que en el equilibrio el valor extraido por jugador va a ser este p ( p (1-S-T) + S) ) + p T, ¿cual seria la estrategia mixta que maximiza la extraccion de valor?. Derivando la funcion, tendriamos la condicion

0 = 2 p (1-S-T) + (S+T)

con solucion

p = (S + T) / 2(S+T-1)

que extraeria un valor por jugador de

[(S + T) / 2(S+T-1)] ( [(S + T) / 2(S+T-1)] (1-S-T) + (S+T) ) = [(S + T) / 2(S+T-1)] ( (S+T) /2)) =

= (S+T)^2 / 4(S+T-1)

Si (S+T)/2 = S, entonces el equilibrio de Nash es tambien la mejor estrategia mixta a la hora de extraer valor. Esto es la diagonal S=T, que en realidad ni siquiera es dominio de Chicken.

Lejos de esta diagonal, el equilibrio de Nash es una estrategia ineficaz, la diferencia seria:

(S+T)^2 / 4(S+T-1) – S T / (S+T-1) = (S-T)^2 / 4(S+T-1)

Es interesante que las soluciones de mayor eficacia dependen solo de S+T, esto es, forman rectas antidiagonales, perpendiculares a la S=T. Una forma grafica de visualizar por tanto la “solucion eficaz” para un juego (1,S,T,0) es proyectar, o trasladar, perpendicularmente la coordenada (S,T) a la diagonal y tomar la solucion de Nash para el juego resultante, llamemosle (2, S+T, S+T, 0).

Otra cosa que podemos observar mirando la forma de p en funcion de S+T, esto es (S + T) / 2(S+T-1), es que p < 1 solo si (S+T) > 2 ó si (S+T)<0. La primera de estas condiciones es tambien, como emos mencionado más arriba, la condicion para que empieze a merecer la pena ponerse de acuerdo para jugar CD o DC alternativamente en vez de jugar por el Reward. A medida que va aumentando (S+T), el valor de p va descendiendo hacia 1/2, confirmando el metodo “gráfico” que hemos sugerido en el parrafo anterior.

Por otra parte, si (S+T)/2 es pues el maximo valor extraible por jugada si los jugadores pudieran adoptar algun metodo para ponerse de acuerdo, otra forma de leer las ecuaciones es que el valor optimo (S+T)/2 recibe de partida una correccion (S+T)/ 2(S+T-1) por el hecho de quedarnos limitados a usar soluciones de estrategia mixta, sin memoria ni contexto de las jugadas anteriores.

La cuestion que quiero enfocar en el siguiente post es. ¿hay alguna modificacion del juego, en terminos de reglas de evolucion, que permita equilibrios sobre estrategias mixtas mas eficaces que el equilibrio de Nash? Esto puede ser factible porque las reglas de update en una simulacion tienen en realidad influencia sobre el punto de equilbrio. La cuestion es si se puede aprovechar esa influencia para ajustarse al optimo de extraccion de una manera razonable, o si simplemente nos desplazamos hacia otro equilibrio sin poder relacionarlo con el óptimo. Pero eso ya sera para el fin de semana.

; en sorte qu’il y a trois contre un à parier que croix arrivera au moins une fois en deux coups.

; en sorte qu’il y a trois contre un à parier que croix arrivera au moins une fois en deux coups. , si l’on considérait, avec d’Alembert, ces trois cas comme également possibles. Mais il est visible que la probabilité d’amener croix au premier coup est

, si l’on considérait, avec d’Alembert, ces trois cas comme également possibles. Mais il est visible que la probabilité d’amener croix au premier coup est  , tandis que celle des deux autres cas est

, tandis que celle des deux autres cas est  ; le premier cas étant un évènement simple qui correspond aux deux évènemens composés, croix au premier et au second coup, et croix au premier coup, pile au second. Maintenant, si, conformément au second principe, on ajoute la possibilité

; le premier cas étant un évènement simple qui correspond aux deux évènemens composés, croix au premier et au second coup, et croix au premier coup, pile au second. Maintenant, si, conformément au second principe, on ajoute la possibilité